La capacidad computacional de los chips que están en todos nuestros dispositivos, incrementa cada año.

Durante las últimas décadas ha seguido la Ley de Moore.

En este artículo te explicaré lo que es la ley de Moore, cómo empezó todo esto, donde estamos hoy y hacia donde vamos.

Si prefieres consumir este contenido en formato de vídeo, ¡dale un vistazo a continuación!

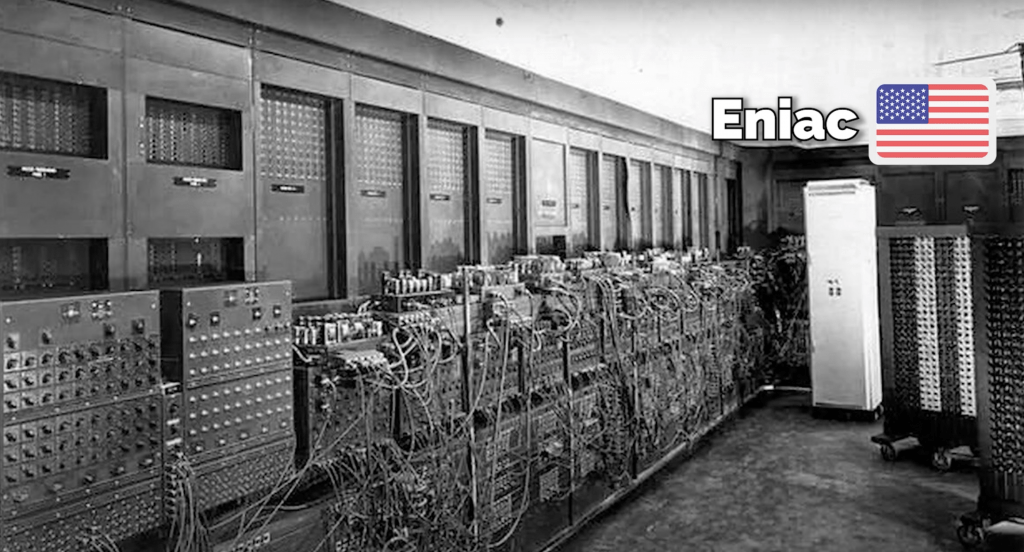

El comienzo de la revolución computacional moderna

El inicio de la revolución computacional moderna se remonta a la Segunda Guerra Mundial, un período que, más allá de su contexto histórico, marcó el nacimiento de la computación tal y como la conocemos. Figuras como Alan Turing en el Reino Unido y Konrad Zuse en Alemania, junto con el desarrollo del ENIAC en Estados Unidos, fueron pioneros que no solo contribuyeron significativamente al esfuerzo bélico sino que también sentaron las bases de la tecnología computacional futura.

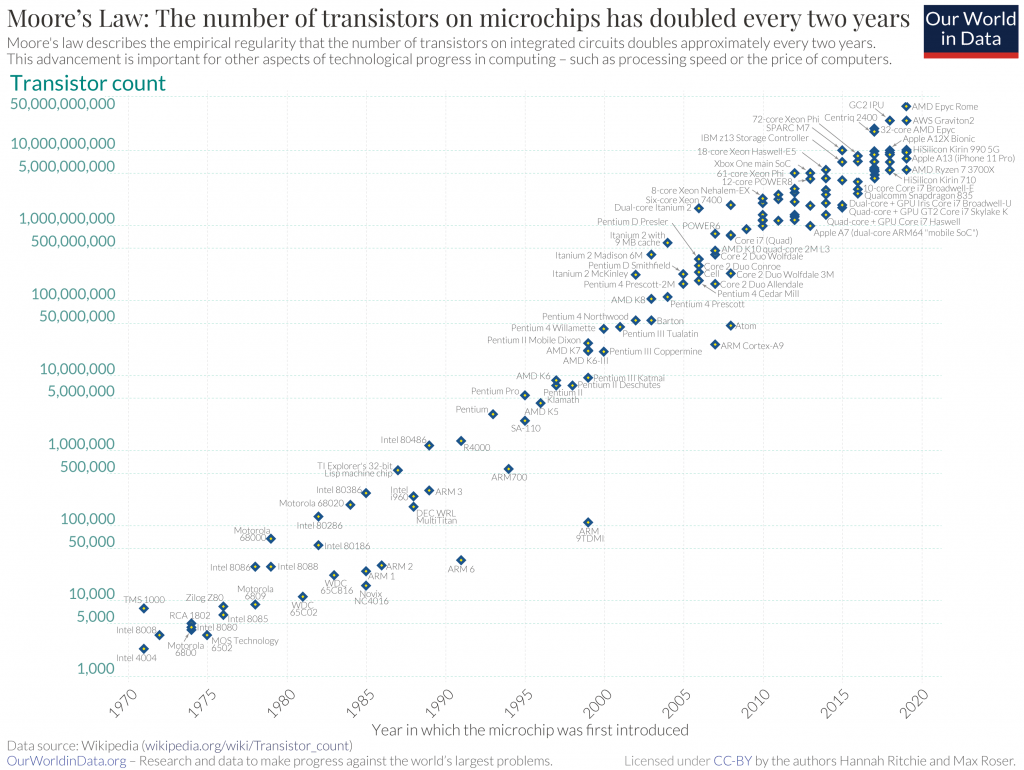

La Ley de Moore y su Impacto

En 1965, Gordon Moore, cofundador de Intel, realizó una observación que se convertiría en un principio rector para la industria tecnológica: el número de transistores en un microchip se duplicaría aproximadamente cada dos años, mejorando así su rendimiento. Esta predicción no solo se ha mantenido válida durante décadas sino que ha sido el motor detrás del desarrollo de dispositivos cada vez más pequeños, rápidos y eficientes, desde ordenadores personales hasta los smartphones que hoy caben en nuestros bolsillos.

Enfrentando los Desafíos: Más Allá de la Velocidad de Reloj

Sin embargo, hacia 2005, la industria comenzó a enfrentarse a un desafío significativo: el aumento de calor generado por chips más potentes. La solución fue un cambio de paradigma hacia el diseño de microprocesadores con múltiples núcleos, lo que permitió continuar mejorando el rendimiento sin el inconveniente del sobrecalentamiento.

La Era del Hardware Especializado para Inteligencia Artificial

La demanda creciente de aplicaciones de IA llevó al desarrollo de hardware especializado, como las Unidades de Procesamiento Gráfico (GPUs), las Unidades de Procesamiento de Tensor (TPUs) y los Motores a Escala de Wafer (WSEs). Estos avances han hecho posible que modelos de IA, que antes requerían días para entrenarse, ahora puedan hacerlo en cuestión de horas o minutos.

Quantum Computing: La Frontera Final

Mirando hacia el futuro, la computación cuántica se perfila como la próxima gran revolución, prometiendo capacidades de procesamiento exponencialmente mayores gracias a los qubits, que pueden existir en múltiples estados simultáneamente. Aunque todavía en sus etapas iniciales, la computación cuántica tiene el potencial de transformar radicalmente el campo de la IA, reduciendo el tiempo de entrenamiento de algoritmos de semanas a minutos o incluso segundos.

Reflexiones Finales

Desde los albores de la computación durante la Segunda Guerra Mundial hasta el umbral de la computación cuántica, hemos sido testigos de una evolución tecnológica sin precedentes. Estas innovaciones no solo han redefinido lo que es posible en términos de procesamiento y análisis de datos sino que también prometen seguir revolucionando el futuro de la inteligencia artificial.

Si te ha fascinado este viaje a través de la historia y el futuro de la tecnología computacional y quieres adentrarte aún más en el mundo de los datos y la IA, te invitamos a descubrir nuestros cursos gratuitos para principiantes en Datademia.

Si buscas convertirte en un analista de datos, el Data Analyst Bootcamp te espera para llevar tus habilidades al próximo nivel.

No dejes pasar la oportunidad de formar parte de esta emocionante era tecnológica.

Fundador de Datademia y formador especializado en análisis de datos, ciencia de datos, ingeniería de datos y negocios.

Ayudo a profesionales a adquirir habilidades prácticas a través de formaciones online en Datademia para impulsar sus carreras. Conecta conmigo en LinkedIn.